مشاور سابق OpenAI؛ هنوز کسی برای هوش مصنوعی انسانگونه آمادگی ندارد

به گزارش گروه دانش و فناوری، براندیج که در زمینه ایمنی هوش مصنوعی فعالیت میکرده در این پست نوشته که آمادگی برای هوش مصنوعی جامع یا AGI به عوامل مختلفی وابسته است. این عوامل شامل نحوهی اجرای فرهنگی ایمنی و امنیت، تاثیر مقررات بر انگیزههای سازمانی و مشکلاتی در زمینه ارائه اطلاعات دقیق در مورد قابلیتهای هوش مصنوعی میشود.

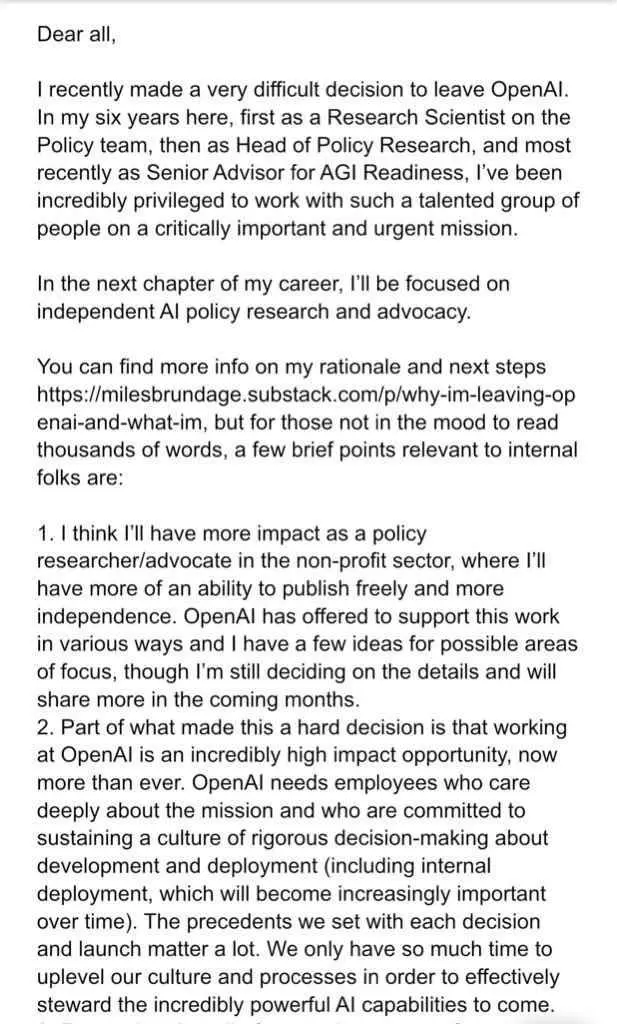

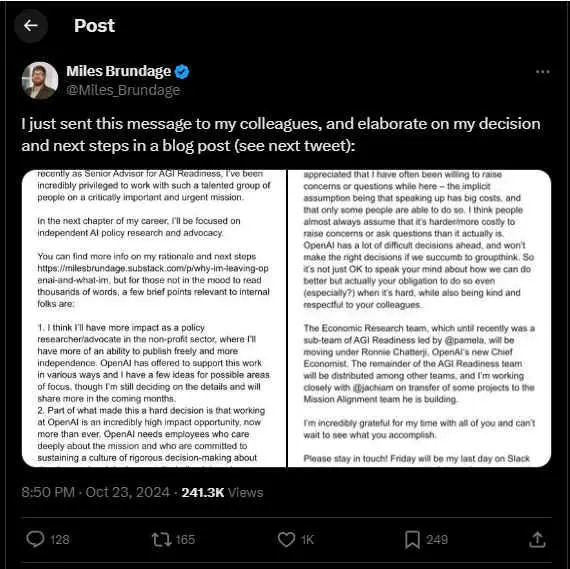

وی در ادامه به یکی از مهمترین دلایل خروجش از این مجموعه نیز اشاره کرده و گفته که به دلیل محدودیتهایی که OpenAI در زمینه تحقیقات و آزمایشها تعیین کرده، تصمیم به خروج از این شرکت گرفته است.

براندیج اولین فردی نیست که از این شرکت جدا میشود؛ پیش از او نیز یان لکه، ایلیا سوتسکور و دو چهرهی کلیدی دیگر نیز از این شرکت به دلایل مشابه جدا شدند. در این میان سوتسکور استارتاپ خودش را با تمرکز بر توسعه هوش مصنوعی انسانگونه (AGI) تاسیس کرد.

یکی دیگر از نکات حائز اهمیت که براندیج به آن اشاره کرده، انحلال تیم «آمادگی AGI» و پیش از آن، تیم «Superalignment» است که به کاهش خطرات بلندمدت هوش مصنوعی پرداخته بود. این تغییرات به نوعی نشاندهنده چالشهای جدی در مدیریت و هدایت پروژههای مربوط به AGI در OpenAI است.

علیرغم تمامی چالشها و اتفاقاتی اخیری که رخ داده، براندیچ اشاره کرده که این شرکت او را در زمینه تامین بودجه؛ اعتبار API و دسترسی به مدلهای اولیه برای برنامههای آیندهاش حمایت خواهد کرد.

انتهای پیام